本文介绍高等数学中的leaky ReLU,以及在神经网络中的应用。

函数原型

leaky ReLU(带泄露的ReLU)

f(x)' = \begin{cases}

1, & \text{if } x \geq 0 \

\lambda, & \text{if } x < 0

\end

原创2024年2月28日小于 1 分钟

leaky ReLU(带泄露的ReLU)

f(x)' = \begin{cases}

1, & \text{if } x \geq 0 \

\lambda, & \text{if } x < 0

\end

ReLU(Rectified Linear Unit 修正的线性单元)

f(x)' = \begin{cases}

1, & \text{if } x \geq 0 \

0, & \text{if } x < 0

\end

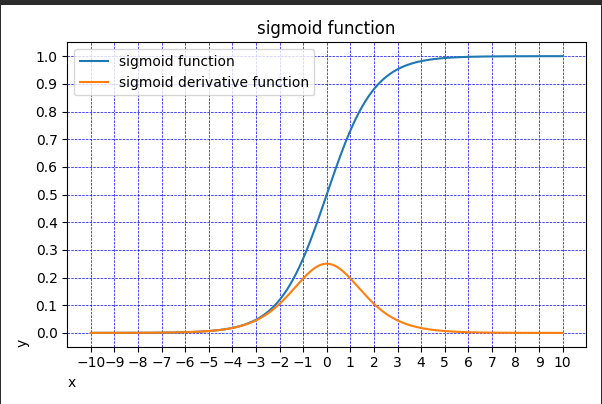

主要用于二分类的输出层

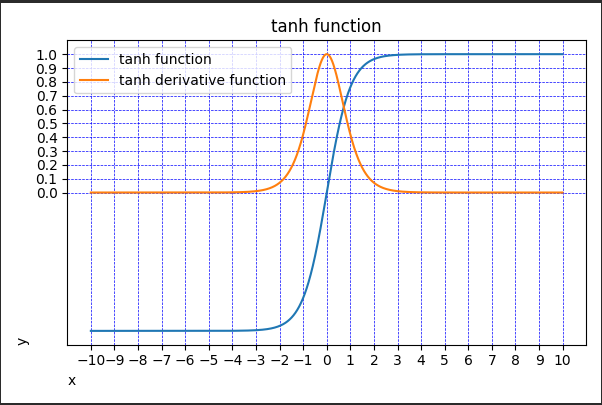

tanh函数又称双曲正切函数

几乎所有场景